Transformer-mallit – järkevää sisältöä kirjaimia ennustamalla

Kirjoittanut: Markus Sjöberg

0:00 / 0:00

Kun keskustelemme tekoälyn tai kielimallien toiminnasta, puhutaan usein transformer-arkkitehtuurille perustuvista ratkaisuista. Tämä teknologia on useimpien modernien kielimallien kuten ChatGPT:n, Clauden tai Geminin taustalla, mutta transformer-malleja käytetään myös muissa generatiivisissa tekoälyty,ökaluissa, kuten kuvageneraattoreissa. Transformer-teknologia on mullistanut tekoälymaailman ja antanut pohjan tekoälytyökaluille, joilla voi tuottaa entistä ymmärrettävämpää ja koherentimpaa sisältöä.

Transformerit esiteltiin vuonna 2017 Googlen tutkijoiden julkaisussa nimeltä ”Attention is All You Need” (Vaswani ym. 2017). Tämä artikkeli toimi pohjana monille nykyisille hienostuneille tekoälyratkaisuille. Ennen transformereita kielimallien kyvyt olivat huomattavasti rajallisempia, ja ne pystyivät lähinnä yksinkertaiseen tekstintäydennykseen tai käännöstehtäviin. Transformerien myötä syntyi mahdollisuus käsitellä laajoja tekstikokonaisuuksia ja tuottaa pitkiä, johdonmukaisia vastauksia, jotka huomioivat koko kontekstin.

Transformer-mallit perustuvat huomiomekanismiin (attention mechanism), joka on niiden toiminnan ydin. Yksinkertaistetusti tämä tarkoittaa, että malli pystyy ”kiinnittämään huomionsa” tekstin eri osiin samaan aikaan ja arvioimaan, mitkä sanat ja ilmaisut ovat yhteydessä toisiinsa (katso tarkempi kuvaus esim. Alammar 2018).Esimerkiksi lauseessa ”Taiteilija maalasi teoksen, koska hän halusi ilmaista tunteitaan” malli ymmärtää sanan ”hän” viittaavan taiteilijaan, koska huomiomekanismi yhdistää nämä sanat toisiinsa. Toisin kuin aiemmat kielimallit, transformerit eivät käsittele tekstiä pelkästään peräkkäin sana kerrallaan, vaan ne voivat tarkastella koko tekstiä rinnakkain. Tämä rinnakkainen käsittely mahdollistaa myös tehokkaamman tietojenkäsittelyn ja nopeamman oppimisen.

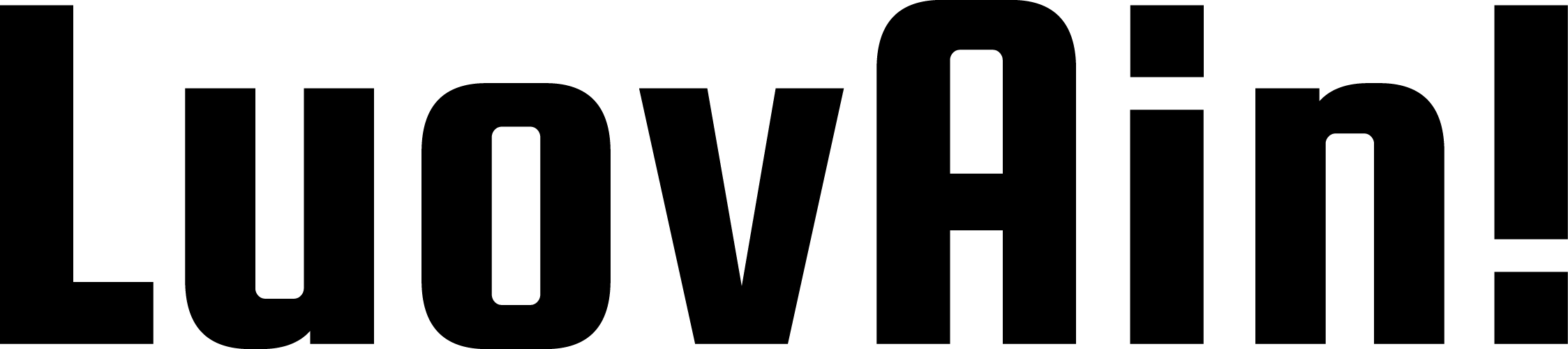

Kun kirjoitat kehotteen kielimallille, teksti ensin jaetadian pieniin osiin, tokeneihin, jotka voivat olla sanoja, niiden osia tai jopa yksittäisiä kirjaimia. Jokainen token muunnetaan numeeriseksi vektoriksi, joka kuvaa sen merkitystä moniulotteisessa merkitysavaruudessa. Tätä prosessia kutsutaan embedding-vaiheeksi (Brown ym. 2020). Malli käyttää huomiomekanismia selvittääkseen, mitkä osat tekstistä ovat yhteydessä toisiinsa, minkä jälkeen se ennustaa seuraavan todennäköisimmän tokenin annetun kontekstin perusteella. Prosessi toistuu, kun malli lisää yhden tokenin kerrallaan vastaukseen, kunnes se on valmis.

Kuvitellaan, että pyydät mallia kirjoittamaan runon auringonlaskusta. Malli käsittelee kehotteesi ja alkaa tuottaa tokeneita yksi kerrallaan. Se ei kuitenkaan valitse sanoja satunnaisesti, vaan ennustaa jatkuvasti, mikä olisi järkevin seuraava sana aiempien sanojen ja lauseiden kontekstissa. Juuri tästä syystä modernit kielimallit voivat tuottaa niin johdonmukaista ja kontekstiin sopivaa tekstiä.

Transformer-mallien voima piilee niiden kyvyssä käsitellä pitkiä konteksteja ja löytää yhteyksiä tekstin eri osien välillä. Ne pystyvät ymmärtämään kontekstia, sopeutumaan erilaisiin tyyleihin, suorittamaan monimutkaisia tehtäviä ja käsittelemään multimodaalista sisältöä (Wolf ym. 2020). Tämä monimuotoisuus on tehnyt transformer-malleista erittäin suosittuja erilaisissa tekoälysovelluksissa luovasta työstä tieteelliseen tutkimukseen.

Kaikesta vaikuttavuudestaan huolimatta transformer-malleilla on myös rajoituksensa. Ne eivät todella ymmärrä tekstiä samalla tavalla kuin ihmiset, vaan niiden ”ymmärrys” perustuu tilastollisiin todennäköisyyksiin. Ne ovat pohjimmiltaan erittäin kehittyneitä ennustusjärjestelmiä, jotka arvioivat, mikä token (sana tai merkki) todennäköisimmin seuraisi tietyssä kontekstissa (Marcus & Davis 2020). Tämä johtaa toisinaan hallusinointiin eli virheellisen tiedon tuottamiseen, vaikka se vaikuttaisi vakuuttavalta. Luovan työn kontekstissa tämä ei välttämättä ole ongelma, mutta faktapohjaisen sisällön luomisessa asia on huomioitava.

Luovan alan ammattilaisille transformer-mallit tarjoavat lukemattomia mahdollisuuksia toimia ideageneraattoreina, kirjoitusapulaisina, tiedonhakutyökaluina ja luovuuden laajentajina. Pelkistetyimmillään transformer-mallit ovat hyvin kehittyneitä tekstin ennustajia, jotka työn taustalla oleva matematiikka on monimutkaistanut valtavan tehokkaiksi. Ilman huomiomekanismia ja transformerin mahdollistamaa rinnakkaista laskentaa kielimallien hyödyntäminen luovassa työssä olisi huomattavasti rajoittuneempaa.

Kuten aiemmin kurssilla on todettu, transformer-mallien tuottamat tekstit voivat toisinaan tuntua pinnallisilta tai ”keskimääräisiltä”. Tämä johtuu siitä, että mallit oppivat opetusdatastaan tyypillisiä kielellisiä rakenteita ja ilmaisutapoja, mutta niiltä puuttuu aito kokemus ja tunne-elämä.

Transformer-mallien käytännön toiminta näkyy selkeästi modernien keskustelevien tekoälyjen, kuten ChatGPT:n, Clauden ja Geminin toiminnassa. Nämä mallit pystyvät tuottamaan hämmästyttävän ihmismäistä keskustelua, vastaamaan monimutkaisiin kysymyksiin ja jopa näennäisesti reflektoimaan omaa toimintaansa. Kun käyttäjä esimerkiksi pyytää mallia pohtimaan vastauksensa rajoitteita tai perustelemaan päättelyketjuaan, malli vaikuttaa pystyvän itsereflektioon ja metakognitioon – ajattelemaan omaa ajatteluaan.

On kuitenkin tärkeää ymmärtää, että tämä reflektiivisyys on pohjimmiltaan illuusio. Kun kielimalli ”pohtii rajoitteitaan” tai ”analysoi ajatteluaan”, se ei ymmärrä, vaan todellisuudessa se ennustaa, millaista tekstiä tällaisessa tilanteessa todennäköisimmin tuotettaisiin (Mitchell & Krakauer 2023). Malli on koulutettu valtavalla määrällä tekstiä, joka sisältää myös ihmisten tekemiä itsearvioita, pohdintoja ja kriittisiä analyyseja. Kun pyydämme mallia reflektoimaan, se tuottaa tekstiä, joka muistuttaa ihmisen tuottamaa reflektiota, mutta taustalla ei ole aitoa tietoisuutta tai ymmärrystä omista prosesseistaan.

Tämä ilmiö näkyy erityisen hyvin tilanteissa, joissa mallia pyydetään korjaamaan virheitään. Malli saattaa vaikuttaa nöyrältä ja itsereflektiiviseltä myöntäessään virheensä ja korjatessaan sen: ”Pahoittelen virhettäni, tarkistettuani asian huomaan, että olin väärässä…” Tosiasiassa kyseessä ei ole aito oivallus tai oppiminen, vaan ainoastaan mallin tuottama todennäköinen vastaus kyseiseen tilanteeseen. Kielimalli ei ”huomaa olleensa väärässä” eikä ”tarkista asioita” – se vain tuottaa tekstiä, joka noudattaa tyypillisiä virheen myöntämisen ja korjaamisen kielellisiä kaavoja

Konkreettinen esimerkki tästä on tilanne, jossa käyttäjä osoittaa mallille faktavirheen: ”Claude, väitit että Suomen presidentti on Sanna Marin, mutta oikea vastaus on Alexander Stubb.” Vaikka Claude vastaisi: ”Olen pahoillani virheestäni, olet aivan oikeassa. Alexander Stubb on Suomen presidentti, ei Sanna Marin”, malli ei todellisuudessa ole ”ymmärtänyt” tehneensä virhettä. Se on ainoastaan tuottanut tilastollisesti todennäköisen vastauksen tilanteeseen, jossa ihminen osoittaa toisen tekemän virheen. Mallin sisäisissä ”uskomuksissa” tai tietorakenteissa ei ole tapahtunut todellista muutosta tai oppimista.

Toisaalta on myös kiistanalaista, missä määrin voimme määritellä ”aidon” reflektion tai metakognition. Jos systeemi kykenee arvioimaan omia tuloksiaan, muokkaamaan toimintaansa aiemman palautteen perusteella ja tuottamaan perusteltuja selityksiä toiminnalleen, voidaanko puhua jonkinasteisesta reflektiosta, vaikka se tapahtuisikin eri mekanismein kuin ihmisillä?

Käytännön esimerkki transformer-mallien toiminnasta on myös niiden kyky mukauttaa tyyliään annettujen ohjeiden mukaan. Jos pyydät mallia ”vastaamaan kuin William Shakespeare”, se pystyy tuottamaan tekstiä, joka jäljittelee Shakespearen tyyliä. Tämä perustuu siihen, että malli on todennäköisesti nähnyt paljon Shakespearen teoksia ja tekstejä, jotka jäljittelevät hänen tyyliään. Transformer-mallin huomiomekanismi kykenee tunnistamaan ”Shakespeare-tyyliin” liittyviä kielellisiä piirteitä ja sanastoa, ja malli käyttää näitä tuottaessaan tekstiä.

Luovassa työssä erityisen mielenkiintoista on transformer-mallien kyky sekoittaa useita erilaisia konsepteja. Esimerkiksi pyyntö ”selitä kvanttifysiikka käyttäen leipomismetaforia” tai ”kirjoita runo, joka yhdistää cyberpunk-genren ja suomalaisen kansanperinteen” tuottaa usein yllättäviä tuloksia. Tämä perustuu transformer-mallien kykyyn yhdistää erillisiä semanttisia alueita ja käsitellä niitä rinnakkain. Tällainen konseptien sekoittaminen on myös ihmisluovuuden keskeinen piirre, ja kielimallit voivat toimia tämän prosessin katalysaattoreina.

Transformer-mallit ovat siis ennen kaikkea tehokkaita kielellisiä työkaluja, jotka voivat tukea luovan työn eri vaiheita ja avata uusia näkökulmia. Niiden parhaat käyttötavat tunnistavat sekä mallien vahvuudet että rajoitukset – ne eivät ole itsenäisiä luovia toimijoita, mutta voivat toimia tehokkaina kumppaneina luovassa prosessissa. Transformer-mallien kehitys jatkuu edelleen voimakkaana, ja tulevat versiot tulevat todennäköisesti laajentamaan edelleen näiden mallien kykyjä.

Multimodaaliset transformer-mallit, jotka pystyvät käsittelemään sekä tekstiä, kuvia että ääntä ovat yleistyneet. Ne ovat mahdollistaneet esimerkiksi entistä tehokkammat kuvageneraattorit, kuten ChatGPT:n Image-1 -mallin, joka kykenee ymmärtämään entistä paremmin sanallisen kehotteen sekä tuottamaan aikasiempaa DALL-E-mallia hienovaraisempia muutoksia kuvien sisällä.